Katarzyna Świerczyńska, „Wprost”: AI wkracza niemal w każdą dziedzinę życia i już jest wykorzystywana także w medycynie. Czy w przyszłości medycyna będzie mogła istnieć bez sztucznej inteligencji?

Marcin Sieniek*: Medycyna to olbrzymia gałąź gospodarki, tu wszystko jest rozdrobnione na wiele chorób, wiele specjalizacji. Nie szedłbym zbyt daleko i nie powiem, że w każdej z tych dziedzin AI się sprawdzi, ale tam, gdzie mamy procesy, które są powtarzalne, gdzie mamy dostęp do odpowiedniej ilości danych, które są sprawdzalne, to myślę, że sztuczna inteligencja będzie w tych obszarach coraz bardziej pomocna.

Tylko trzeba zwrócić uwagę, że medycyna jest dość konserwatywną dziedziną nauki, tu z każdą nowością trzeba przejść wiele walidacji, certyfikacji. AI będzie pełnić w przyszłości dużą rolę w medycynie, tego jestem pewien, ale póki co, to jeszcze na pewno potrwa.

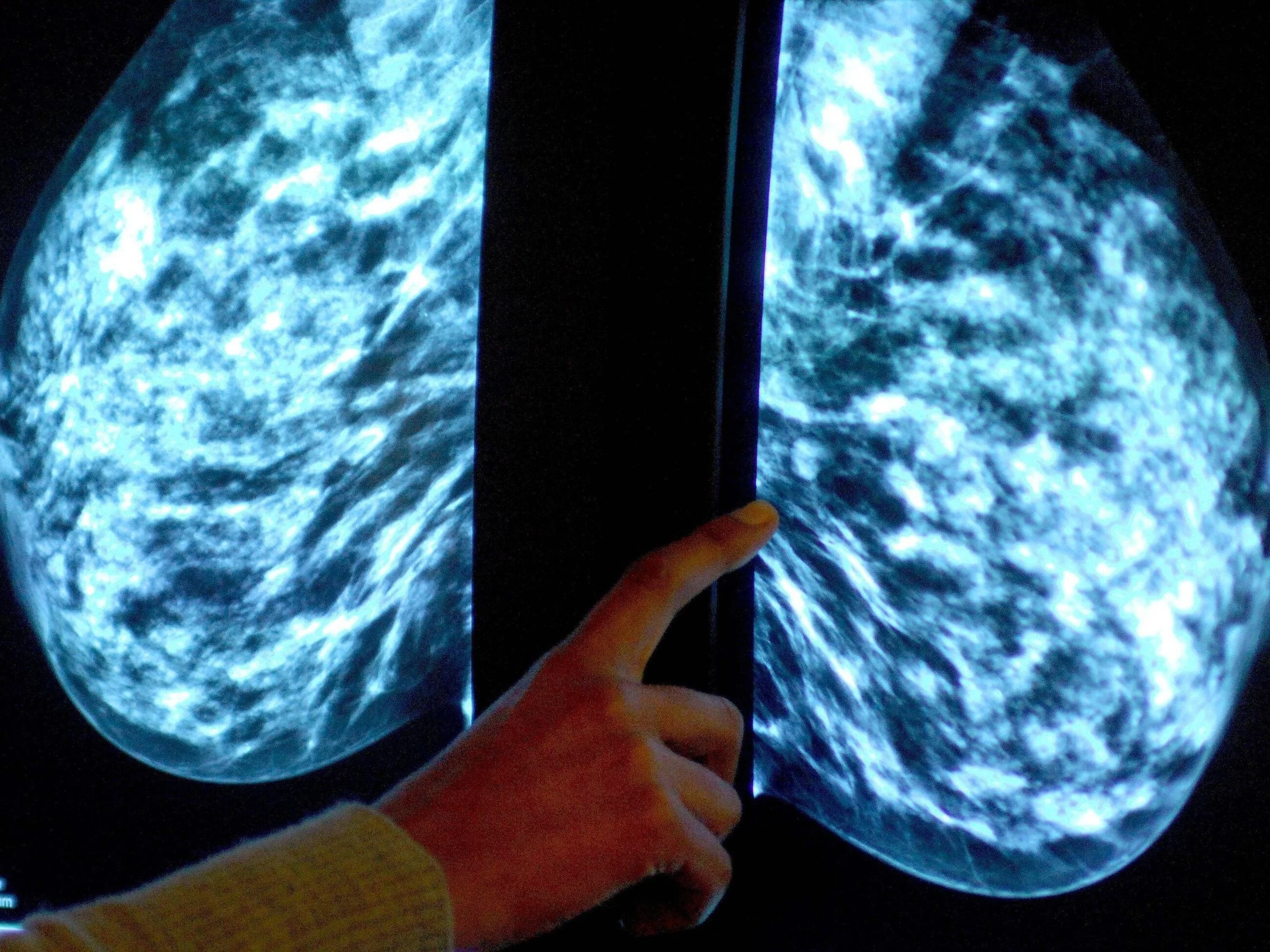

Pan nad jednym z takich projektów pracuje. Chodzi o wykorzystanie AI przy mammografii i wczesnego wykrywania raka piersi.

Diagnostyka, a szczególnie programy przesiewowe rzeczywiście są tą dziedziną, gdzie dzięki wsparciu AI możemy wiele zdziałać, bo tu pracujemy na analizowaniu dużych ilości ustrukturyzowanych danych.

W przypadku programu przesiewowego raka piersi, możemy trenować sztuczną inteligencję, aby potrafiła odpowiedzieć na jedno pytanie: czy dana pacjentka ma podwyższone ryzyko wystąpienia raka piersi albo czy zdiagnozowany u niej rak już się rozwija?

W tym sensie mammografia jest stosunkowo łatwiejszą domeną wykorzystania AI. Choć nie wszystkie obrazy medyczne mają tę cechę: tylko na podstawie obrazowania klatki piersiowej lekarz może zdiagnozować 200 różnych chorób, co do niedawna przerastało możliwości uczenia maszynowego.

A teraz AI będzie mogła to wszystko zrobić za lekarza?

Nie do końca. AI może poprawić trafność diagnoz, przyspieszyć ten proces i obniżyć koszty. Ale lekarze mają dużo większą rolę do odegrania nawet jeśli urządzenia diagnostyczne będą autonomiczne.

AI może poprawić trafność diagnoz, przyspieszyć ten proces i obniżyć koszty. Ale ja widzę jeszcze jeden ważny aspekt: dzięki wykorzystaniu AI będziemy mogli zwiększyć dostępność do programów przesiewowych.

To ważne szczególnie w krajach, gdzie brakuje lekarzy radiologów, gdzie na tę diagnostykę czeka się zbyt długo. Zresztą takie rzeczy już się dzieją. To np. jeden z najbardziej dojrzałych programów realizowanych przez Google, czyli system do autonomicznej diagnozy retinopatii cukrzycowej u osób chorych na cukrzycę, który jest z powodzeniem wdrażany w Indiach, pracujemy też teraz w tej kwestii z rządem Tajlandii. Więc to są pierwsze przykłady, gdzie AI rzeczywiście została wdrożona w dużej skali.

Wróćmy do Pana projektu. Jak wygląda praca nad tym, aby AI pomogła skutecznie i szybko wyłapywać kobiety zagrożone rakiem piersi?

Kiedy zaczynaliśmy pięć lat temu, to był malutki zespół składający się z dwóch inżynierów – mnie i mojego kolegi – oraz jednego radiologa. Postawiliśmy na samym początku tezę, że głębokie uczenie maszynowe jest w stanie pomóc wykrywać zmiany chorobowe w obrazach medycznych. Bo skoro maszyna jest w stanie identyfikować twarze czy tablice rejestracyjne, to dlaczego nie wykorzystać tego w medycynie w badaniach obrazowych? Oczywiście to wszystko nie jest też takie proste, bo np. niektóre zmiany na obrazie są wielkości kilku pikseli, rozdzielczość mammogramów jest dość wysoka, niekiedy potrzebna jest koordynacja odczytu kilku różnych widoków równocześnie. Więc nie mieliśmy pewności, czy to zadziała…

Ale się udało i efektem jest m.in. publikacja w „Nature”, której jest Pan współautorem.

Tak, bo nasz projekt z upływem czasu zaczął się rozwijać, zespół powiększać. Razem ze specjalistami z Londynu udało się stworzyć model, który dorównał lekarzom precyzją interpretacji na historycznych danych. Ta publikacja wywołała szeroką dyskusję, chociaż trzeba jeszcze raz podkreślić, że na ten moment to wciąż praca na danych historycznych, a więc nie sytuacji, że pacjent dopiero przychodzi i my mamy zdecydować, co dalej. Teraz testujemy to wszystko właśnie w kontekście możliwości wykorzystania tego, że tak powiem, w świecie rzeczywistym, w praktyce. Pracujemy obecnie nad certyfikacją naszego modelu w Europie. To ciężki i długi proces. W międzyczasie jeszcze pojawił się COVID-19 i wtedy postanowiliśmy wykorzystać technologię, którą dysponowaliśmy także w inny sposób. Wszyscy wiemy, jak przez pandemię opóźniły się i wręcz zatrzymały wszystkie programy profilaktyczne i przesiewowe. Czas oczekiwania na diagnozę wydłużył się do miesięcy.

Znamy to też z polskich realiów. Diagnostyka nowotworów wręcz stanęła w miejscu.

Dokładnie. Nawet gdy centra badań przesiewowych zostały otwarte po lockdownach, pacjentka przychodziła na badanie i potem miesiącami czekała na odczyt. Dlatego też, we współpracy ze szpitalem w Chicago, wdrożyliśmy system, który pozwalał ocenić wynik mammografii od razu. Wtedy, jeśli pojawiło się coś niepokojącego, pacjentka mogła zostać na dalszą diagnostykę tego samego dnia, a nie narażając się na długotrwałe oczekiwanie na interpretację badania czy zbędne ryzyko ekspozycji na COVID przy kolejnych wizytach. Możemy się pochwalić bardzo dobrymi efektami, które niedługo będziemy publikować w prasie medycznej. Dodam, że obecnie również kilka szpitali brytyjskich otrzymało grant na realizację naszego systemu. Tam system diagnostyki wygląda tak, że każdy obraz ocenia dwóch radiologów. Jeśli się ze sobą nie zgadzają, dochodzi do tego jeszcze jeden radiolog i jest dyskusja.

W przypadku braków kadrowych, jednego z dwóch specjalistów mogłaby zastąpić AI. I jeśli będzie rozbieżność między oceną lekarza a systemem, wtedy pojawi się ten kolejny lekarz i ponowna ocena.

To bardzo przyspieszy czas diagnozy i będzie odpowiedzią na palący problem braku radiologów, z którym boryka się dziś Wielka Brytania.

Zadam teraz bardziej osobiste pytanie. Jest Pan informatykiem, inżynierem. Jak to się stało, że zainteresował się Pan medycyną i konkretnie mammografią?

Niektóre rzeczy po prostu się zdarzają. Oczywiście nie było to zaplanowane, Idąc na studia informatyczne, w ogóle nie myślałem o takim kierunku rozwoju. Kiedy zaczynałem swoją karierę w Google w Polsce wiele lat temu, byłem w zespole, który zajmował się poszukiwaniem stron internetowych, które mogłyby zamieszczać nasze reklamy. Nasz zespół osiągnął naprawdę dużo, a w międzyczasie przeniosłem się do Stanów i zacząłem się rozglądać za nieco bardziej stymulującym projektem. Akurat uruchamianych było kilka nowych projektów Google Health.

Nabrałem wtedy przekonania, że chciałbym zrobić coś takiego „z impetem”, coś co w szerszym rozumieniu będzie naprawdę wartościowe, przyniesie pozytywne efekty dla dobra innych ludzi, będzie dobre dla świata. To niekoniecznie musiała być mammografia, ale świetnie się złożyło, że akurat ten zespół był dostępny.

Wspomniał Pan, że jesteście na etapie certyfikacji w Europie swoich rozwiązań w diagnostyce raka piersi. To kiedy realnie możemy spodziewać się, że rzeczywiście będzie to wykorzystywane w szpitalach – że pójdę zrobić mammografię i będę wiedziała, że nie tylko lekarz, ale i system opracowany przez Pana zespół przeanalizuje obraz?

Mam nadzieję, że system zacznie działać w szpitalach pod koniec tego roku lub na początku przyszłego roku. Nawiązaliśmy współpracę z iCAD, globalnym liderem w dziedzinie technologii medycznych i wykrywania raka, którego urządzenia wdrożone są w tysiącach placówek w USA i Europie, w tym w Polsce. Przekazaliśmy im licencję na nasz model badawczy mammografii AI. Nasz partner będzie pracował nad walidacją i włączeniem naszej technologii mammograficznej AI do swoich produktów. W wyniku tego wdrożenia technologia, którą zbudowaliśmy, również będzie wykorzystana w praktykach klinicznych w celu poprawy wykrywania raka piersi i oceny ryzyka zachorowania na raka dla ponad dwóch milionów osób rocznie na całym świecie.

Oczywiście warto wspomnieć, że gdy mówimy o „urządzeniach medycznych” nie chodzi tu o fizyczne instalacje, których wdrożenie wiąże się np. z zakupem drogich kart graficznych. Mówimy o systemie, który działa w chmurze. To sprawia także, że dane są bezpieczne.

„Doktor Google” będzie jeszcze mądrzejszy? Sam Pan pewnie wie, że tak złośliwie mówią lekarze o pacjentach, którzy próbują sami się diagnozować w sieci.

Nie jestem zwolennikiem autodiagnozy, ale z pewnością systemy sztucznej inteligencji mogą nam na wielu płaszczyznach pomóc. Jeden z naszych produktów już teraz na przykład ma opcję rozpoznawania na podstawie zdjęcia zmian na skórze. Nie nazywamy tego diagnozą, ale użytkownicy i użytkowniczki mogą wyrobić sobie pewne pojęcie o tym, czy w ogóle powinni się niepokoić i pójść do lekarza. W USA na wizytę u dermatologa czeka się miesiącami, więc to naprawdę może być pomocne.

Myślę, że wiele osób zadaje sobie dziś pytanie: czy w przyszłości będzie nas leczyć sztuczna inteligencja? Pracuje Pan też nad projektami mającymi uczyć systemy sztucznej inteligencji medycznego języka…

Tych projektów jest więcej, ja zajmuję się między innymi tym, aby szkolić system sztucznej inteligencji w umiejętności nie tylko systematyzowania konkretnej wiedzy medycznej, ale też korelowania jej z obrazem.

To może pozwolić lekarzowi zadać bardzo konkretne pytanie dotyczące np. leków zalecanych przy konkretnym rodzaju guza. Pracuję nad takim systemem bazowym, który będzie mógł potem być podstawą wielu różnych aplikacji medycznych skierowanych zarówno do lekarzy, jak i konsumentów.

Są pewne procesy, gdzie AI będzie szybciej się rozwijać. Teraz to głównie systemy, które wspierają lekarzy. To znaczy, że na końcu to lekarz podejmuje decyzję. Ale przecież mamy już systemy, które działają – na przykład wspomniany system badania wzroku w kierunku retinopatii cukrzycowej – który uzyskał wszystkie pozwolenia i działa z powodzeniem.

Myślę, że to ogromna szansa, ale i jednocześnie ogromna odpowiedzialność.

Dlatego podczas naszych prac zawsze bardzo dbamy o transparentność i ściśle współpracujemy ze środowiskiem naukowym i medycznym. Uważam, że w przyszłości lekarze rzeczywiście będą mogli skupić się przede wszystkim na podejmowaniu decyzji, na najtrudniejszych przypadkach. Sztuczna inteligencja wesprze ich natomiast w bardziej mechanicznych czynnościach i analizowaniu danych.

*Dr Marcin Sieniek, Google Staff Software Engineer – szef zespołu inżynierów pracujących nad wykorzystaniem AI w diagnostyce nowotworów.

Nauka to polska specjalność

Wielkie postacie polskiej nauki

Przeczytaj inne artykuły poświęcone polskiej nauce

Projekt współfinansowany ze środków Ministerstwa Edukacji i Nauki w ramach programu „Społeczna Odpowiedzialność Nauki”